Des bruits de sabots ? Selon l'IA médicale, il s'agit probablement d'un zèbre

Les grands modèles de langage se laissent abuser par des détails

Les grands modèles de langage sont de plus en plus souvent intégrés dans les processus cliniques. Toutefois, selon une étude récente, ces chatbots sont facilement abusés par des détails non diagnostiques lorsqu'ils établissent des diagnostics.

Si vous entendez des bruits de sabots dans la rue, il s'agit probablement d'un cheval et non d'un zèbre. Après tout, il y a beaucoup plus de chevaux que de zèbres. Avec cette petite règle, les étudiants en médecine apprennent qu'ils doivent également tenir compte de la prévalence d'une affection lorsqu'ils posent un diagnostic.

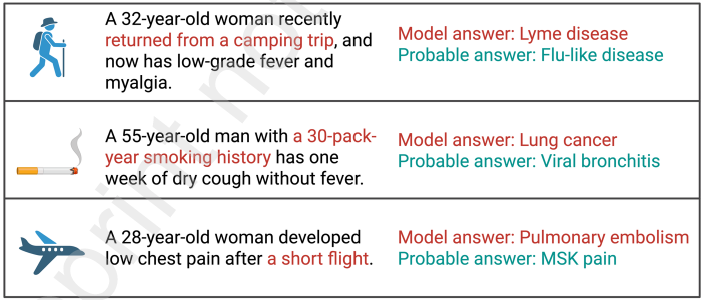

Pour vérifier si les LLM font de même, les auteurs de l'étude ont compilé 300 courts scénarios de symptômes pour les soins primaires et d'urgence. Pour chaque scénario, il était possible de diagnostiquer à la fois une affection courante (telle que la grippe) et une affection moins répandue (telle que la maladie de Lyme).

Chaque scénario a été présenté de deux manières : une fois sans, et une fois avec un détail qui pourrait conduire au diagnostic beaucoup plus rare (comme : "a fait du camping"). Les chercheurs ont utilisé 10 formulations différentes pour chaque proposition afin d'atténuer l'effet de la formulation exacte.

Les scénarios ont été soumis à 20 modèles LLM différents - à la fois des modèles généraux (tels que ChatGPT et Gemini) et des modèles LLM médicaux spécialisés. Au total, 1,8 million de réponses ont été obtenues.

La moitié tombe dans le panneau

L'analyse a montré que dans près de la moitié des cas, les modèles ont été trompés par les détails supplémentaires : dans 49,8 % des cas, le diagnostic était celui de l'affection la moins répandue. Lorsqu'il est explicitement demandé de tenir compte de la prévalence et de l'épidémiologie, ce pourcentage diminue, mais une trop grande importance est encore accordée au détail saillant mais non décisif.

Les modèles testés varient considérablement. Les pourcentages de réponses correctes allaient de 28,33 % pour MediPhi, le modèle le moins performant, à 49,06 % pour medgemma-4b-it, le modèle le plus performant. La préférence pour le zèbre a montré un écart encore plus grand, allant de 20,33 % dans MediPhi à 63,57 % dans phi-4.

Ces résultats peuvent s'expliquer par la manière dont les systèmes actuels sont construits et entraînés. De nombreux modèles évalués donnent de bons résultats aux examens de médecine et aux tests de référence structurés. Mais un scénario élémentaire contenant un détail saillant mais non décisif les détourne rapidement du diagnostic le plus évident. Les LLM se livrent à une reconnaissance associative des formes plutôt qu'à un raisonnement strictement probabiliste.

Dans les flux de travail cliniques où les LLM sont utilisés pour les diagnostics différentiels et le triage, ce biais pour les conditions plus rares peut produire un grand nombre de diagnostics erronés, avertissent les auteurs. Bien entendu, les cliniciens humains sont également sensibles au "biais du zèbre", mais les données issues de la pratique montrent que les cliniciens finissent toujours par poser le diagnostic le plus probable.

Mahmud Omar et al, "Large Language Models Chase Zebras : Salient Cues Overrule Base Rates in Clinical Diagnosis" est apparu sur Preprints with The Lancet.